1.自动采集网站内容

网站优化需要定时更新发布文章内容,每天又没有那么多文章可写,纯靠手动更新也让很多站长难以坚持下去,所以很多站长都会进行网站采集来完成内容填充,那么网站采集出来的内容一定就会很差吗?大家都知道网站采集需要借助各种采集工具,将网上的各种文章资源整合下来,但是纯采集的文章可能会被搜索引擎算法打击,百度也发布了飓风算法来打击这一现象。

2.网站信息采集

飓风算法旨在严厉打击恶劣采集行为和站群问题,将覆盖百度搜索下的PC站点、H5站点、智能小程序等内容那么采用网站采集的方法我们一定要了解飓风算法是针对什么打击的:第一是跨领域采集网站,就是你采集的内容与主题不相关,比如你的网站做的是口红,你却采集篮球相关的内容。

3.数据采集网址

第二是采集痕迹比较明显的网站,对于采集的信息和排版混乱且图片打不开,逻辑不同,这样就是有特别明显的采集痕迹第三是采集多篇内容不同的文章进行组合,整体文章杂乱无章、阅读体验性差了解到上述这些被飓风算法打击的行。

4.网站文章自动采集发布

为后我们就要避免,那怎么才能做好网站采集呢?1.我们在采集内容时,可以输入多个与主题相关的关键词增强文章的相关度。因为在采集工具中的文章内容有几万篇,就像鱼鱼cms采集一篇文章可输入十个关键词。

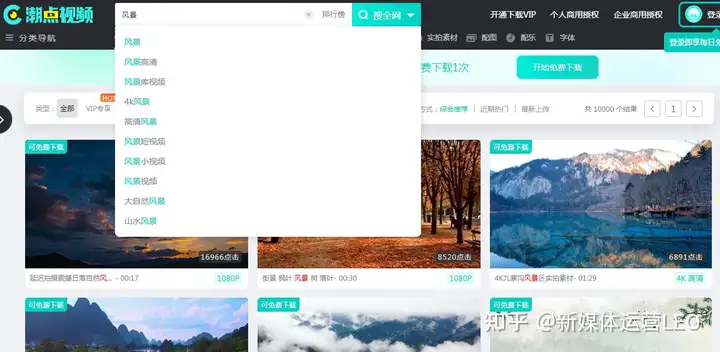

5.信息采集库

2.对采集的文章进行优化,一般采集过来的文章可能会出现排版、内容等细小问题,而且采集的内容都是纯文字的,需要自己修改整理可再加入一些图片进行优化3.页面架构的完善,旨在相关性和丰富度,抓住这两个核心,做内。

6.网站资料采集

页排名就会很容易做采集的注意事项和要点就差不多是这些,总体来说就是不能将采集到的文章直接发布,在满足用户体验和需求方面多做优化,不能让百度看出来你的文章是采集出来的,这样的采集站还是可以做出来的举报/反馈