为了更好地适应软文风格,我们将重新生成标题,并详细探讨使用Python爬虫技术获取网址的相关内容。

一、背景简介 如今,信息时代的快速发展使得互联网成为了人们获取信息的重要途径,因此,网络数据的获取也变得尤为关键。而Python作为一门功能强大且简单易用的编程语言,成为了网络爬取的热门工具之一。它不仅具有出色的库支持,如BeautifulSoup和Scrapy,还有优秀的网络请求库Requests。本文将分享如何使用Python爬虫技术高效获取网址的经验与技巧。

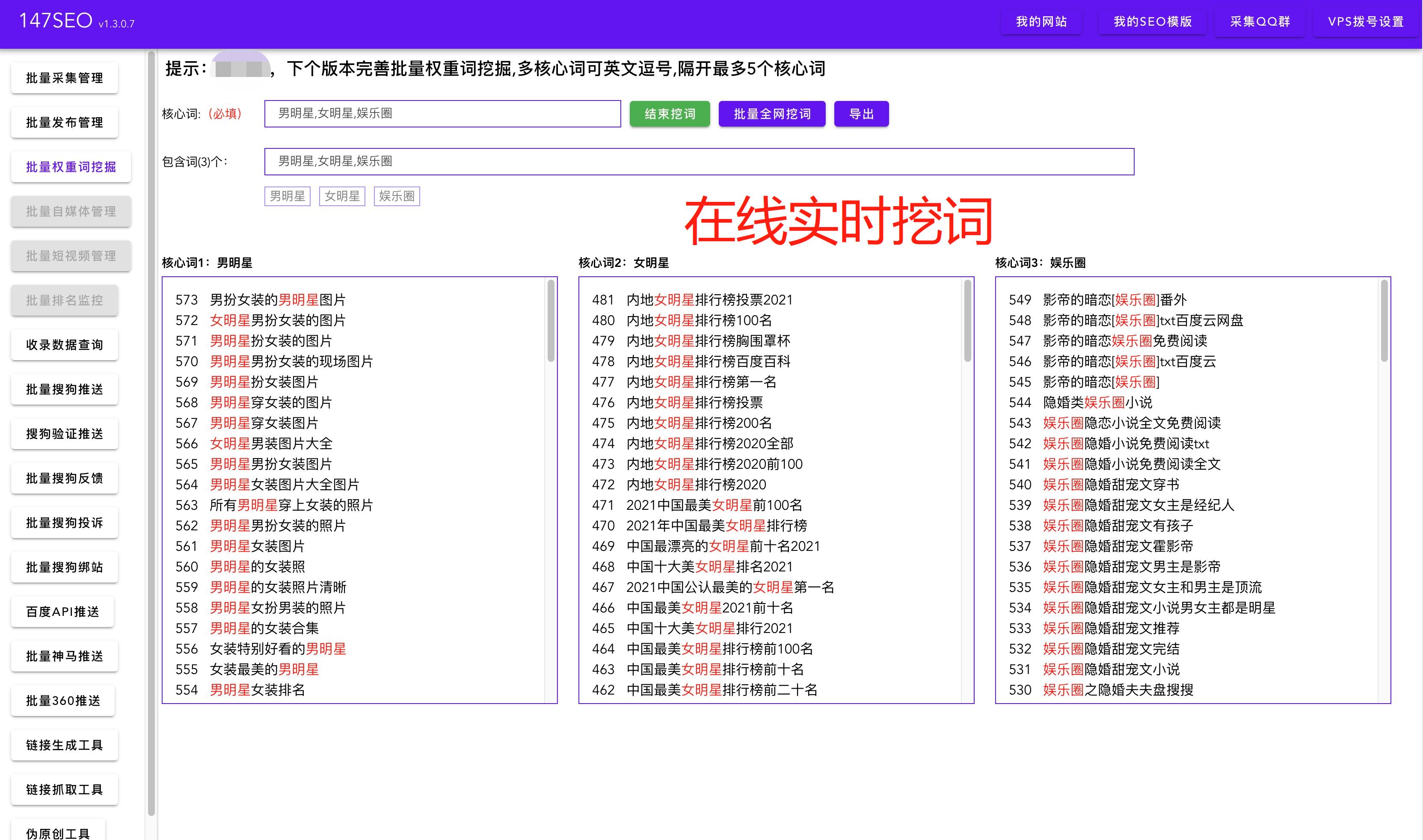

二、技巧与实践 1.网络请求库的选择 Python中有许多网络请求库可供选择,其中Requests库是其中之一。它简单易用,且功能强大,可以高效处理HTTP请求和响应。使用Requests库,我们可以轻松获取网页的HTML源码,从而提取网址。

2.解析网页内容 在获取网页的HTML源码后,我们需要使用相应的解析工具,如BeautifulSoup库,来解析网页内容并提取需要的网址。BeautifulSoup提供了丰富的功能,可以灵活地处理HTML和XML,帮助我们快速准确地获取目标数据。

3.多线程与异步请求 当需要获取大量网址时,为了提高效率,我们可以使用多线程或异步请求技术。通过同时运行多个线程或发起异步请求,可以并行地处理多个网页,加快网址获取的速度。

4.反爬虫对策 在进行网页爬取时,我们需要注意网站可能对爬虫进行限制的反爬虫策略。为了规避这些限制,我们可以模拟浏览器行为,如设置User-Agent、添加延时等手段。此外,还可以使用代理IP来隐藏真实IP地址。

5.数据处理与存储 获取到网址后,我们可能需要对数据进行处理、清洗或存储。我们可以使用Python中的各种数据处理和存储库,如Pandas和MySQLdb,来进一步加工和存储网址数据。

三、总结 本文介绍了使用Python爬虫技术获取网址的一些技巧与实践。通过选择合适的网络请求库、解析网页内容、使用多线程或异步请求、规避反爬虫策略以及进行数据处理与存储,我们可以高效地获取所需的网址。Python爬虫技术在数据挖掘、信息收集等领域发挥着重要作用,希望本文能对想要学习或深入研究Python爬虫的读者有所帮助。