互联网时代,网站是人们获取信息和交流的重要渠道。每个网站背后都隐藏着各种各样的数据,而探索和发掘这些数据可以带来许多意想不到的发现。本文将介绍使用爬虫技术来爬取一个网站的二级页面数据,并通过网络数据挖掘,揭示出网站背后的无限可能。

爬虫技术是一种自动化获取网页数据的技术。通过分析网页的结构和内容,爬虫程序可以模拟人的行为,在网页上进行点击、浏览和获取数据的操作。在爬取一个网站的二级页面数据时,爬虫程序可以自动访问每个页面,并提取出其中的关键信息,如标题、正文、图片等。

一个网站的二级页面是指从首页进入后的各个子页面,通常包含了更详细和丰富的内容。对于有大量二级页面的网站,手工获取其所有数据是一项繁琐且耗时的工作。而使用爬虫技术,可以快速、准确地获取这些页面的数据,大大提高了数据获取的效率。

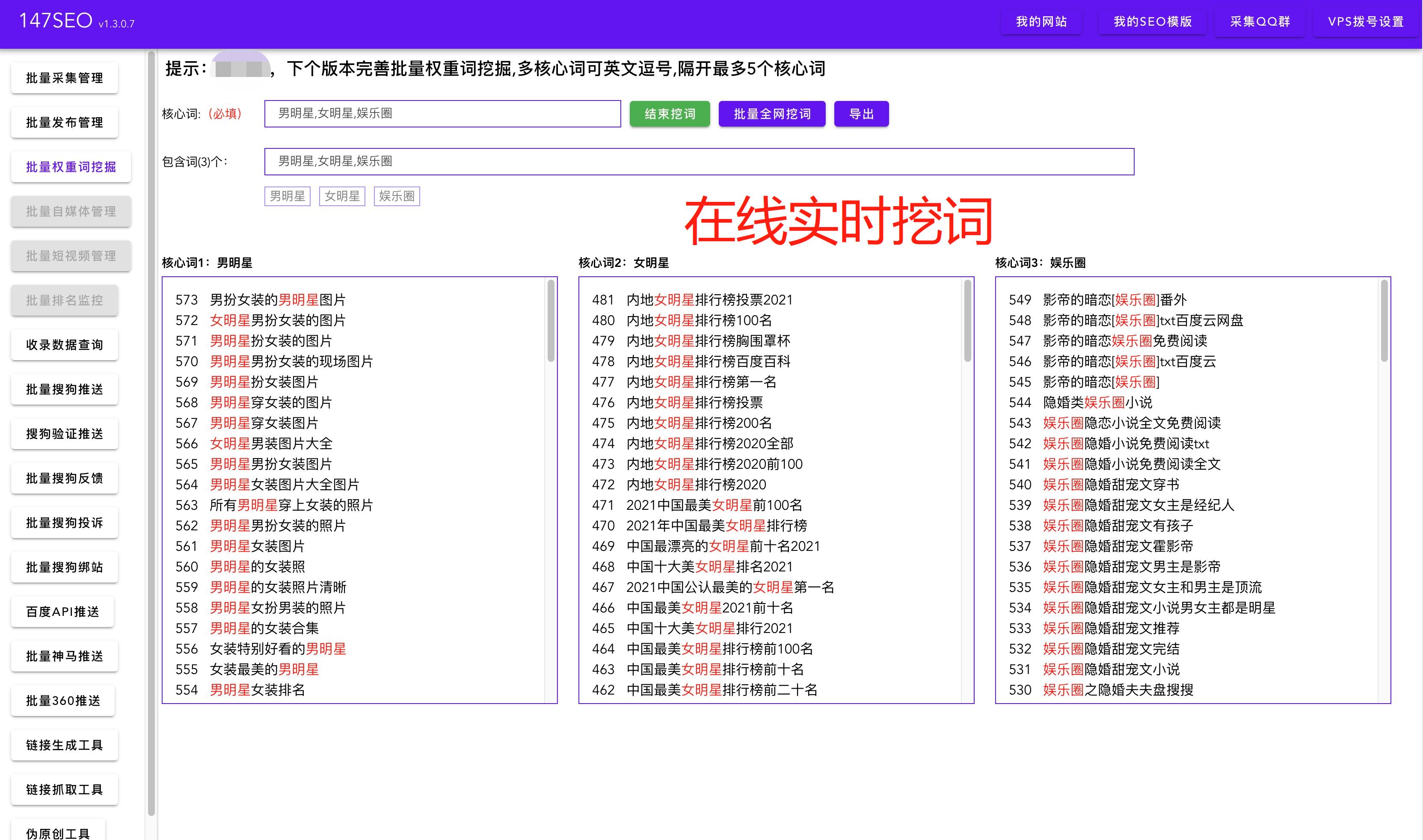

在爬虫程序中,我们通过提取页面的标签和特定内容来获取数据。例如,我们可以使用XPath来提取页面的标题标签,将其作为文章的标题。通过一些文本处理技术,我们可以重新生成一个符合软文风格的标题,吸引读者的眼球。同时,我们还可以解析页面中的关键词和描述标签,为文章添加有助于搜索引擎优化的元数据,提高文章的曝光度。

而对于内容字段,我们可以通过分析网页结构和正文标签来提取文章的正文内容。爬虫程序可以将页面上的文本进行合并和提取,并进行进一步的清洗和处理,以确保提取到的正文内容完整、准确,符合软文风格。

通过爬取一个网站的二级页面数据,我们可以探索隐藏在大量页面背后的不同主题和内容。这些数据可以用于市场调研、竞争情报、舆情分析等领域。通过网络数据挖掘的技术,我们可以从这些数据中寻找规律、挖掘价值,为企业决策提供有力支持。

当然,在进行网站爬取时,我们也需要遵守一些法律和道德规范。在爬取过程中,我们应尊重网站的运营者和用户的权益,遵守网站的相关条款和规定。同时,我们需要关注数据的使用和存储安全,确保数据的合法性和隐私保护。

总之,通过爬取一个网站的二级页面数据,我们可以深入挖掘和发现网站背后的无限可能。爬虫技术和网络数据挖掘为我们带来了更多的机会和可能性。让我们利用这些技术,开启数据的探索之旅,揭示出更多有价值的发现与洞察。