在信息爆炸的时代,获取准确、实时的数据对于企业和个人来说至关重要。然而,随着互联网的发展,众多网站和pingtai上的数据变得越来越庞大和复杂,要手动从中提取所需信息往往费时费力。这时候,爬虫技术就可以派上用场了。

爬虫技术是一种自动化获取网页数据的技术。通过模拟浏览器的行为,爬虫程序可以访问网页、提取数据,并保存到本地或者其他数据库中。与传统的手动提取数据方式相比,爬虫技术不仅能够自动化执行操作,还可以实现大规模的数据采集和处理,提高工作效率。

爬虫技术的实现基于网络通信和数据解析。首先,爬虫程序通过发送HTTP请求和接收响应来模拟浏览器与服务器之间的通信。然后,它会根据网页的结构和特定规则提取所需的数据。最后,通过数据解析和清洗,爬虫程序将提取到的数据转化为可读性高、结构化良好的格式,如CSV、JSON等。

在实际应用中,我们可以使用各种编程语言来编写爬虫程序。Python是一种开发爬虫的流行语言,拥有丰富的库和模块支持。例如,我们可以使用Python的requests库发送HTTP请求,使用BeautifulSoup库解析HTML,或者使用Scrapy框架进行大规模的数据爬取。

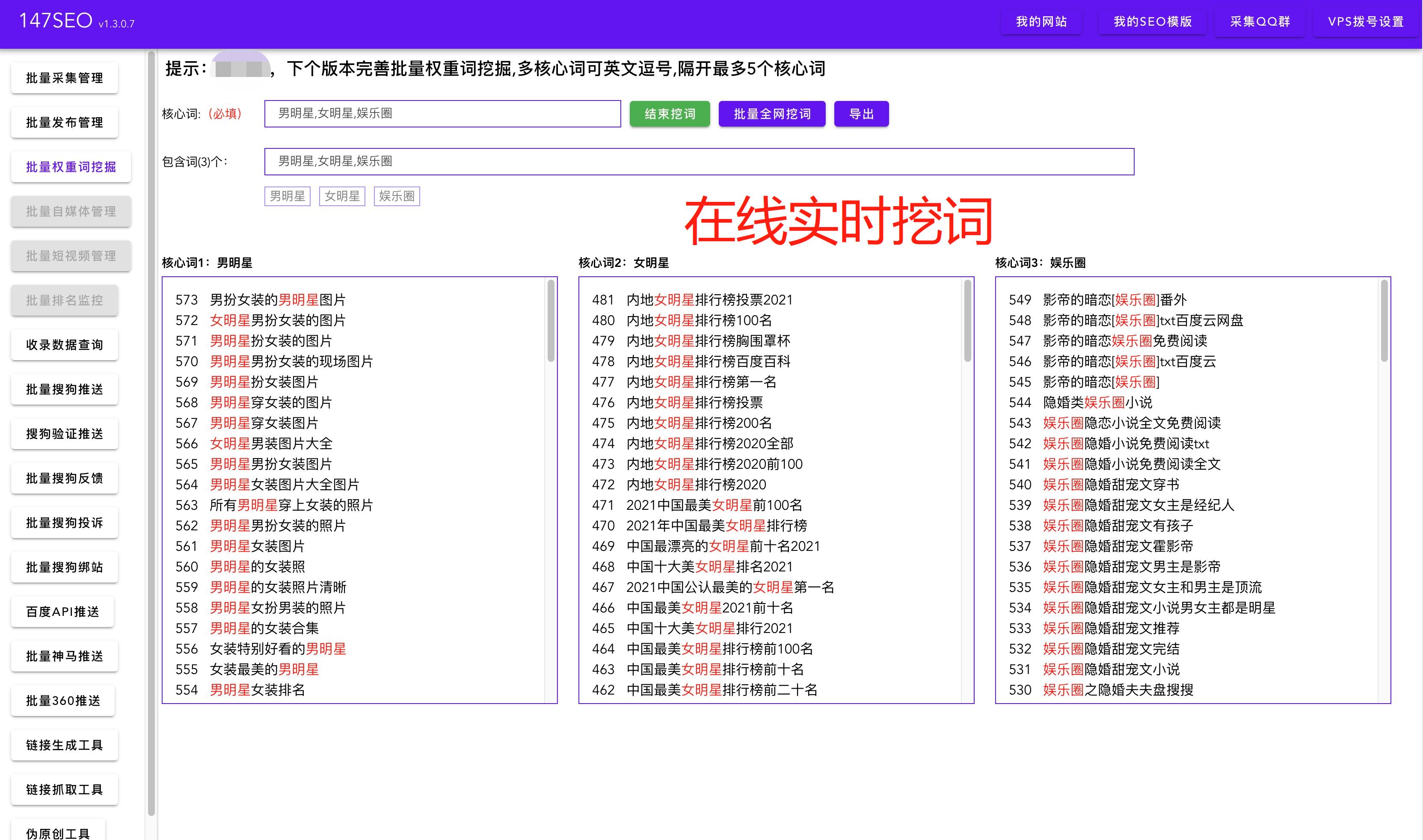

除了编写代码,还有一些常用的数据采集工具可以帮助我们快速获取网页数据。例如,Octoparse是一款功能强大的可视化网页数据采集工具,可以通过简单的拖拽和配置实现复杂的数据采集任务。另外,import.io是一个zaixian的数据采集pingtai,它提供了一种简单易用的方式,让用户能够从网页中提取所需的数据,并将其保存为结构化格式。

总之,爬虫技术是一种强大的工具,可以帮助我们轻松获取网页数据。通过使用爬虫技术,我们可以快速而准确地获取所需的信息,提高工作效率。同时,选择合适的编程语言和工具也是使用爬虫技术的关键。希望本文对于读者在数据采集和数据处理方面有所帮助,让大家能够更好地利用爬虫技术来获取有价值的数据。