在信息时代,数据是非常重要的ZY。无论是市场竞争分析、学术研究还是新闻报道,掌握最新、最全面的数据都能获得竞争优势。而互联网上的海量数据成为了我们获取信息的主要途径。然而,要从互联网上获取大量的数据并不容易,这就需要利用爬虫技术来进行网页数据抓取。

爬虫是一种自动获取互联网数据的程序,它能够模拟人类在浏览器中访问网页的行为,进而从中提取所需的数据。下面,我们将介绍如何使用爬虫抓取网页数据,并提供一些技巧和注意事项。

第一步是选择合适的爬虫框架。目前,主流的爬虫框架有Scrapy、BeautifulSoup、PyQuery等。Scrapy是一个功能强大的Python爬虫框架,它支持异步处理和分布式部署,适用于大规模的数据抓取任务。BeautifulSoup和PyQuery是用于解析网页的库,它们可以方便地提取出网页中的数据。

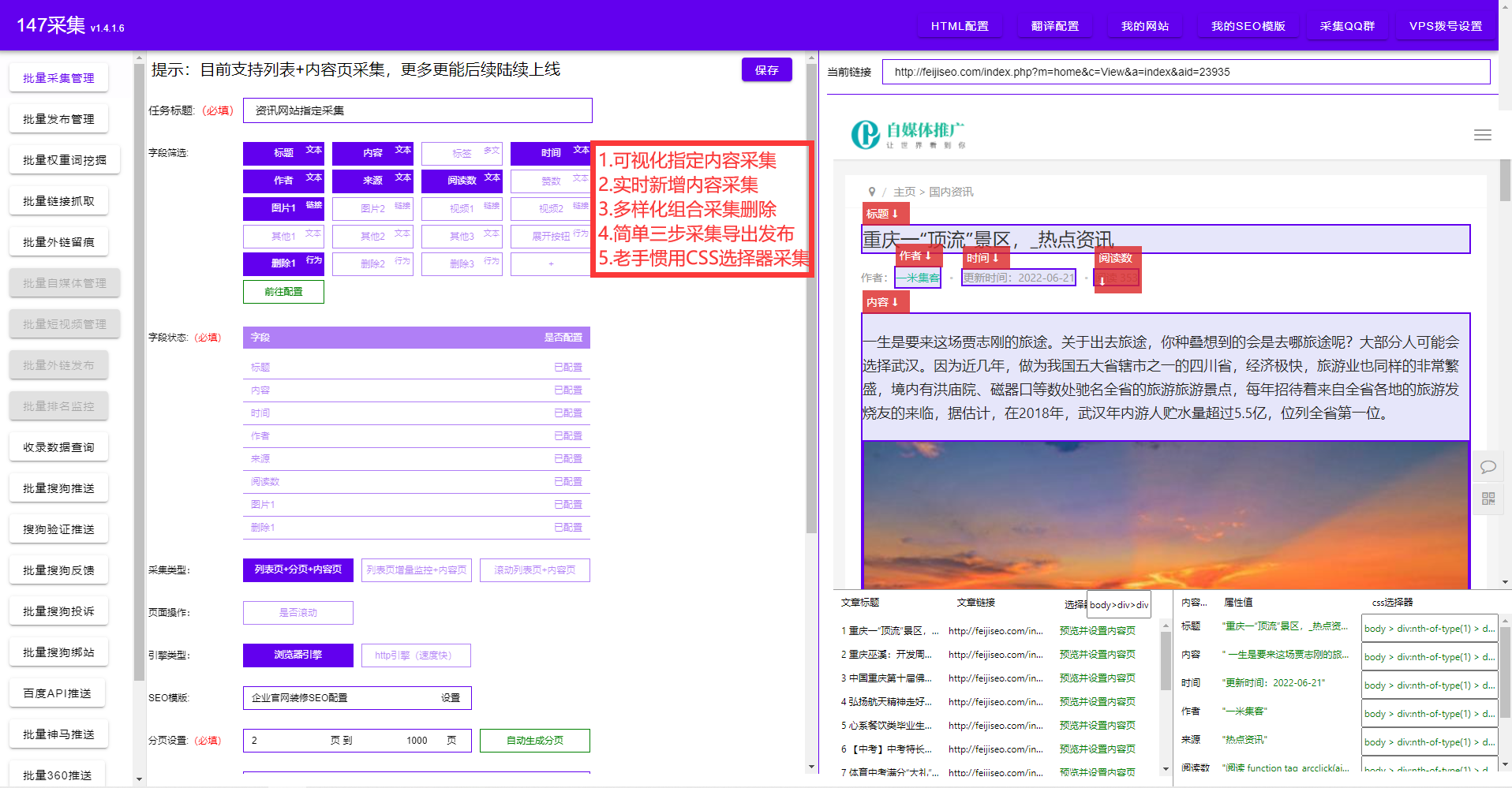

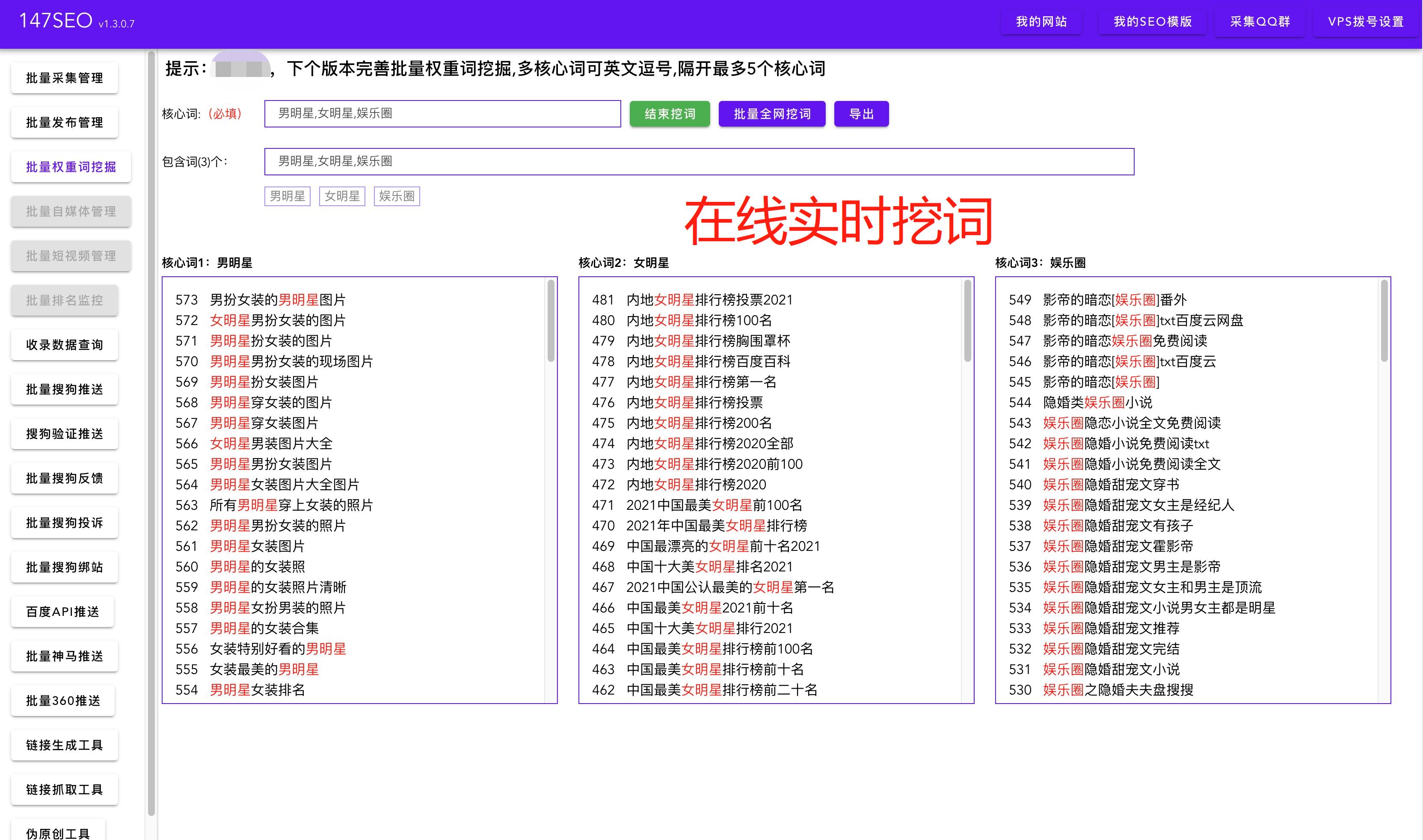

第二步是分析目标网页的结构。在进行数据抓取之前,我们需要先了解目标网页的结构,包括标签、类名、ID和CSS选择器等。通过观察网页源代码或使用浏览器的开发者工具,我们可以找到目标数据所在的位置,并确定需要提取的内容。在解析网页时,可以使用BeautifulSoup或PyQuery来处理HTML或XML结构,并提取出所需的数据。

第三步是编写爬虫程序。根据目标网页的结构和内容需求,我们可以使用所选的爬虫框架来编写爬虫程序。通常,爬虫程序需要包括请求网页、解析网页、提取数据和保存数据的步骤。在请求网页时,可以使用Python的requests库来发送HTTP请求,并获取网页的响应。在解析网页和提取数据时,可以利用BeautifulSoup或PyQuery等库来处理网页内容,并提取出所需的数据。最后,可以将提取到的数据保存到本地文件或数据库中。

在编写爬虫程序时,我们还需要考虑一些技巧和注意事项。首先,由于爬虫程序会发送大量的请求,为了避免对目标网站造成过大的负担,我们应该设置合理的请求间隔和限速。其次,有些网站对爬虫进行了反爬虫限制,我们需要了解并遵守相关的规则和协议。另外,为了确保爬虫程序的稳定性和可靠性,我们可以设置重试机制、异常处理和日志记录等功能。

总之,使用爬虫技术抓取网页数据是一项非常有意义和有挑战性的工作。通过选择合适的爬虫框架、分析网页结构、编写爬虫程序并遵守相关规则,我们可以有效地获取所需的数据并应用于各种应用场景。希望本文对于初学者能够提供一些帮助,并鼓励大家探索和创新在数据抓取领域的技术。