爬虫技术是当今互联网时代不可或缺的关键技能之一,通过爬虫技术,我们可以在短时间内获取到海量的网络数据,并进行进一步的分析和应用。本文将介绍爬虫爬取数据的流程和实用技巧,帮助读者了解这一技术的应用方法和注意事项。

一、数据爬取的流程

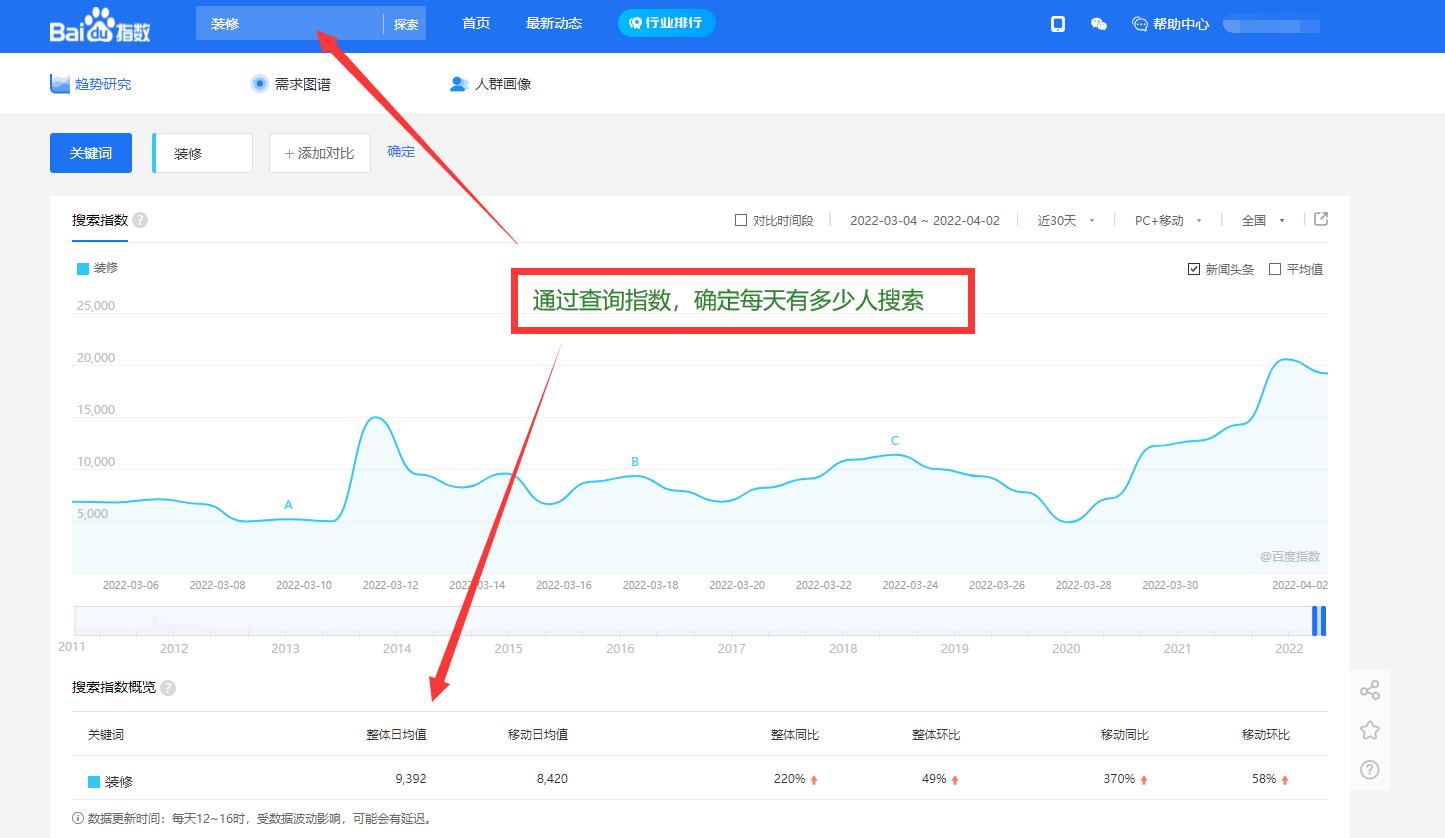

1.确定爬取目标:在开始爬虫之前,我们首先需要确定自己要爬取的目标,例如某个网站的新闻文章、商品信息等。

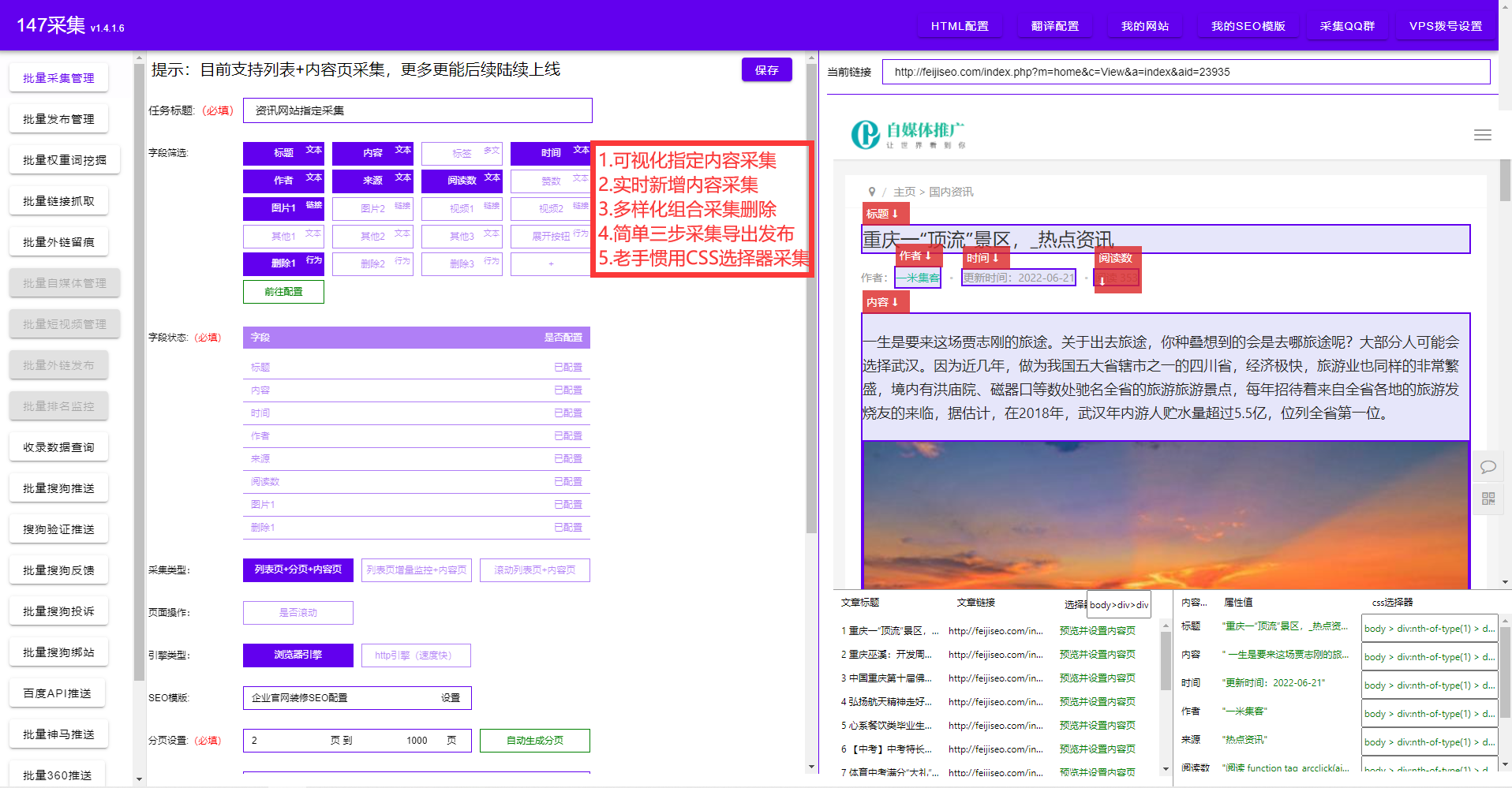

2.分析目标网站:在爬虫之前,我们需要分析目标网站的页面结构和数据组织方式,确定爬取的相关要素,如网页URL、HTML标签、数据存储格式等。

3.编写爬虫程序:根据前面的分析,我们可以使用不同的编程语言编写爬虫程序,例如Python、Java等。通过发送HTTP请求,获取目标网页的HTML源代码。

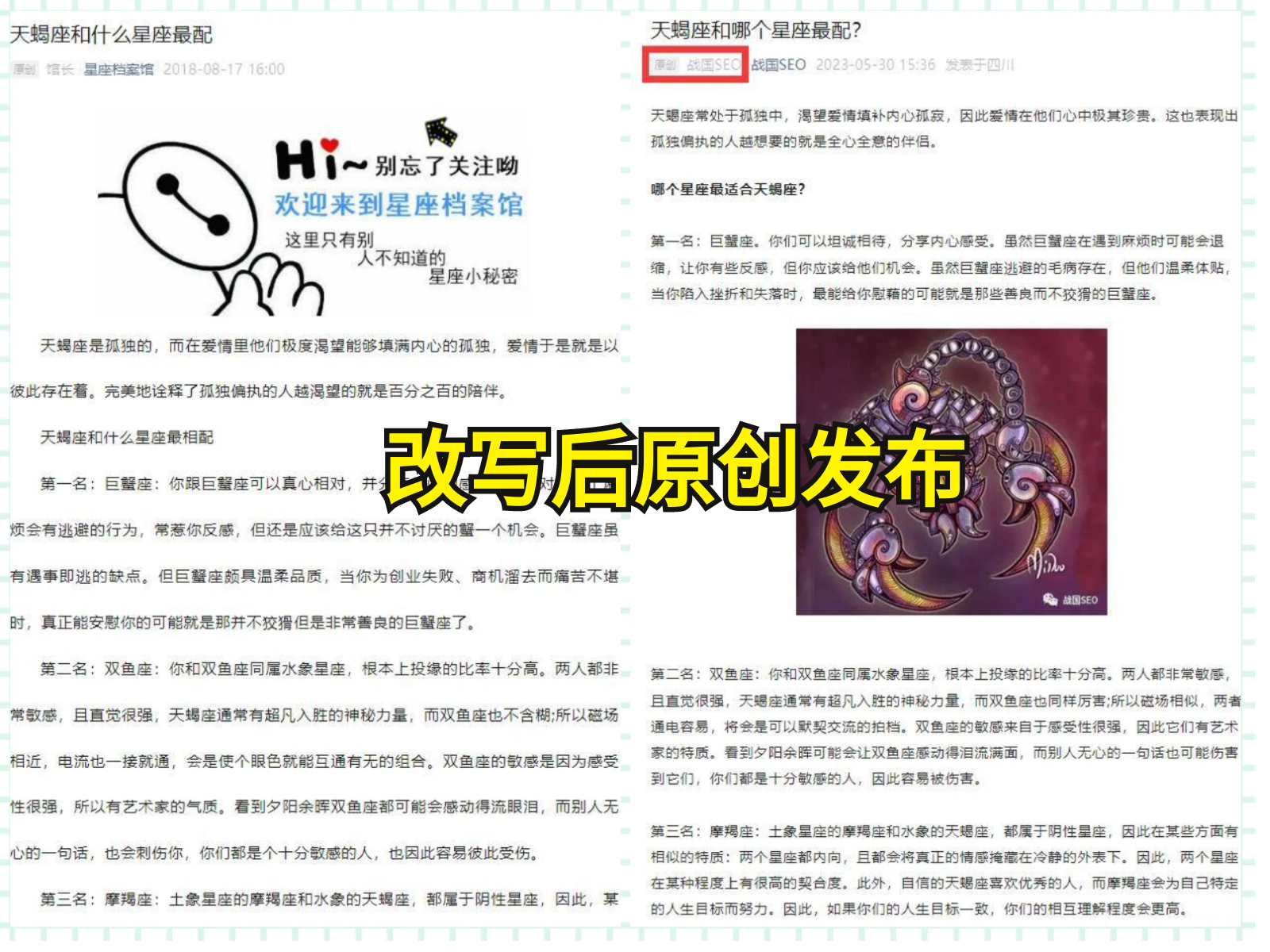

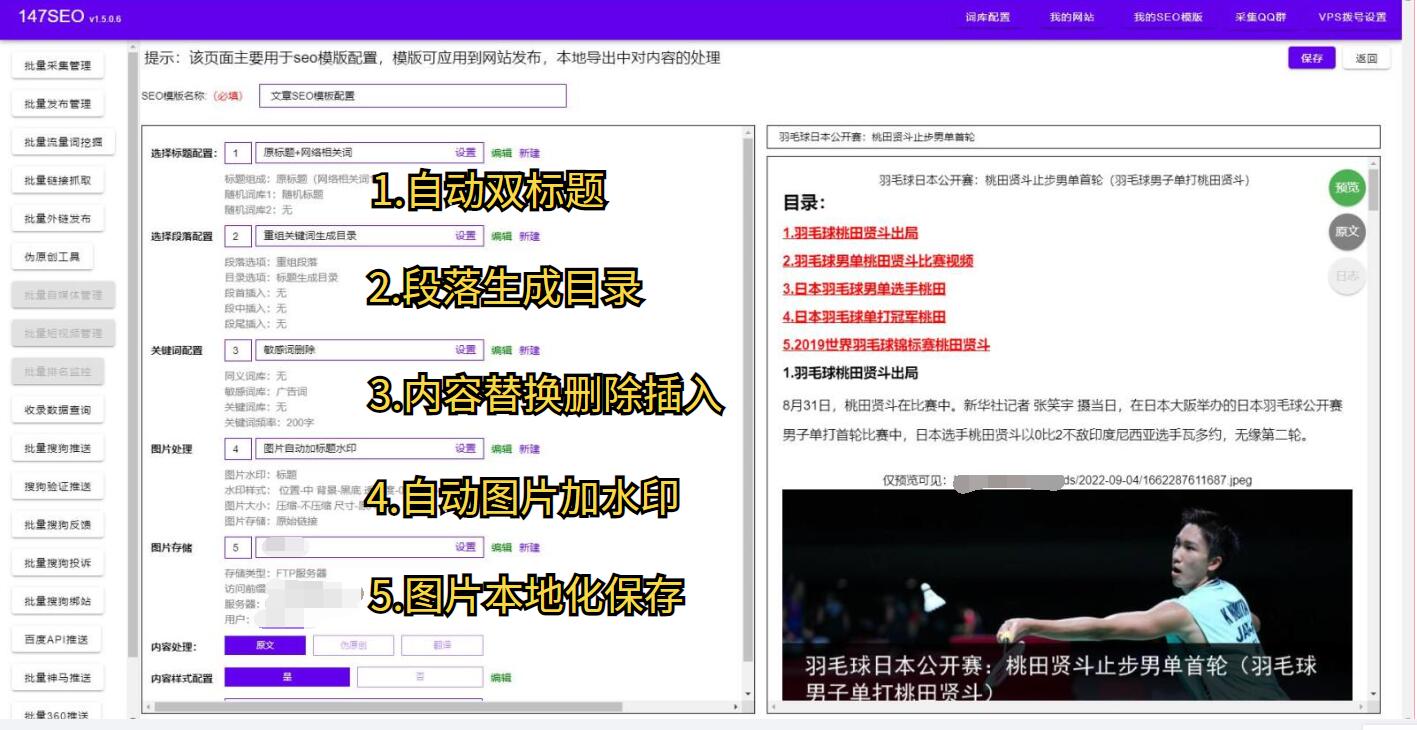

4.解析数据:获取到HTML源代码后,我们需要使用解析库对数据进行解析,提取出我们需要的信息,并将其存储为可处理的格式,例如JSON、CSV等。

5.存储数据:将解析后的数据存储到本地文件或数据库中,以便后续分析和应用。

二、数据爬取的实用技巧

1.设定合适的请求头:为了避免被目标网站识别为爬虫,我们需要设置合适的请求头,包括User-Agent、Referer等信息,使请求看起来像是来自真实用户的访问。

2.处理反爬机制:有些网站会设置反爬机制,例如限制并发请求数量、验证码等。我们需要通过设置合适的延时、使用代理IP、验证码识别等手段来应对这些机制。

3.使用缓存策略:为了提高数据爬取的效率,我们可以使用缓存策略,将已经爬取并解析的数据保存起来,并在后续爬取过程中优先使用缓存数据,减少重复爬取。

4.管理任务调度:对于大规模的数据爬取任务,我们可以使用任务调度框架,如Celery、Scrapy等来管理和并发执行任务,提高爬取效率。

总结:本文介绍了爬虫爬取数据的流程和实用技巧,帮助读者了解和掌握这一重要的技术。数据爬取可以广泛应用于数据分析、舆情监测、市场竞争分析等领域,帮助企业和个人获取并利用有价值的数据信息。但在使用爬虫技术时,我们也需要遵守相关法律法规和网站的使用规定,以确保合法、合规的数据采集行为。