随着大数据时代的来临,数据获取已经成为很多行业中不可或缺的环节。想要从互联网中获取所需的数据,传统的手动收集已经远远不能满足需求。而数据爬虫则成为了一种高效、自动化的解决方案。

##爬虫入门

###什么是数据爬虫?

数据爬虫(WebSpider)是一种程序,可以自动化地从互联网上收集、提取所需的信息。它会模拟人类的浏览器行为,自动访问网页、解析网页内容,并将想要的数据保存下来。

###爬虫基础知识

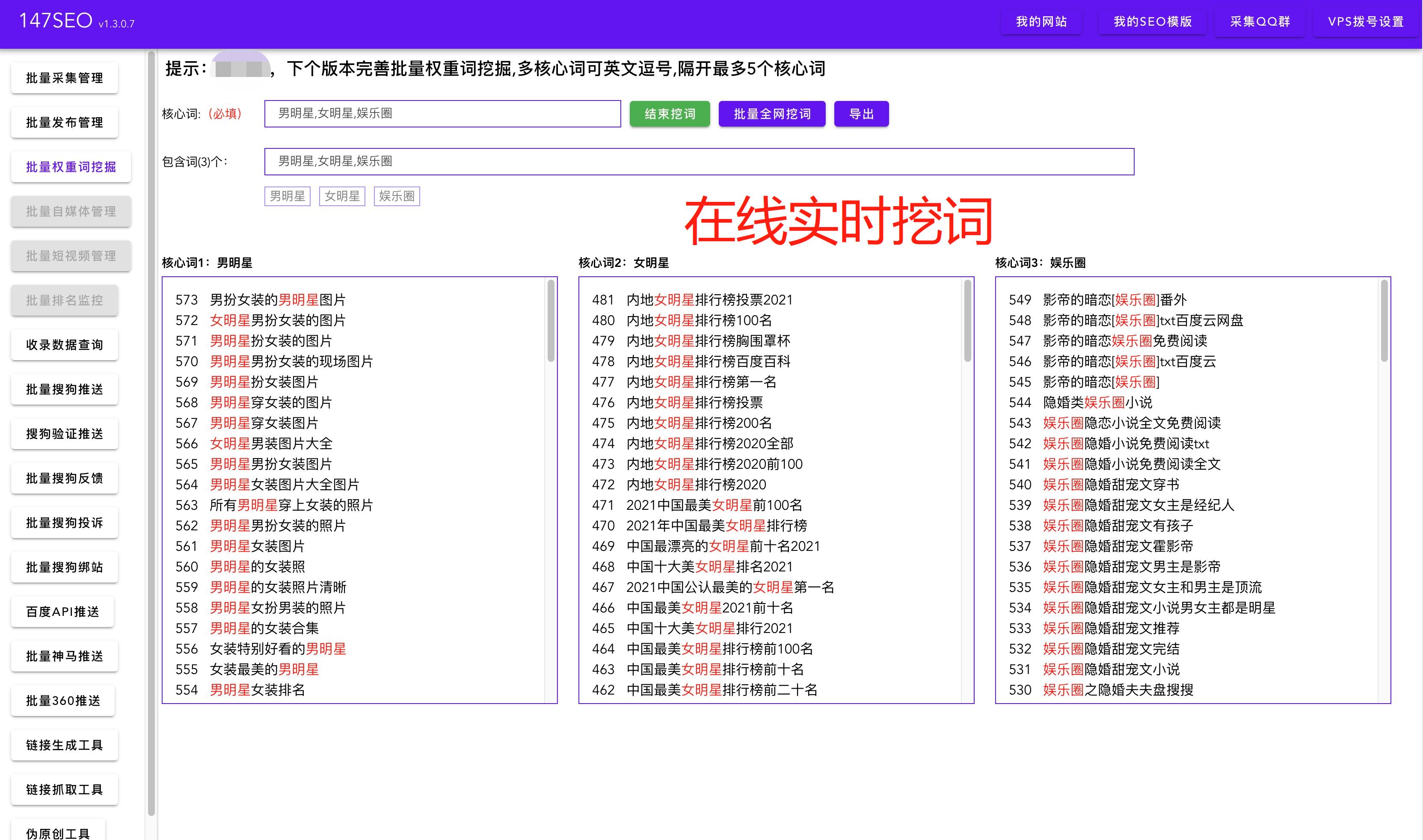

在开始学习爬虫之前,需要掌握一些基础知识: -网络基础:HTTP协议、HTML、CSS、JavaScript等。 -编程语言:Python、Java、JavaScript等,其中Python是最常用的爬虫语言。 -爬虫框架:Scrapy、BeautifulSoup等。

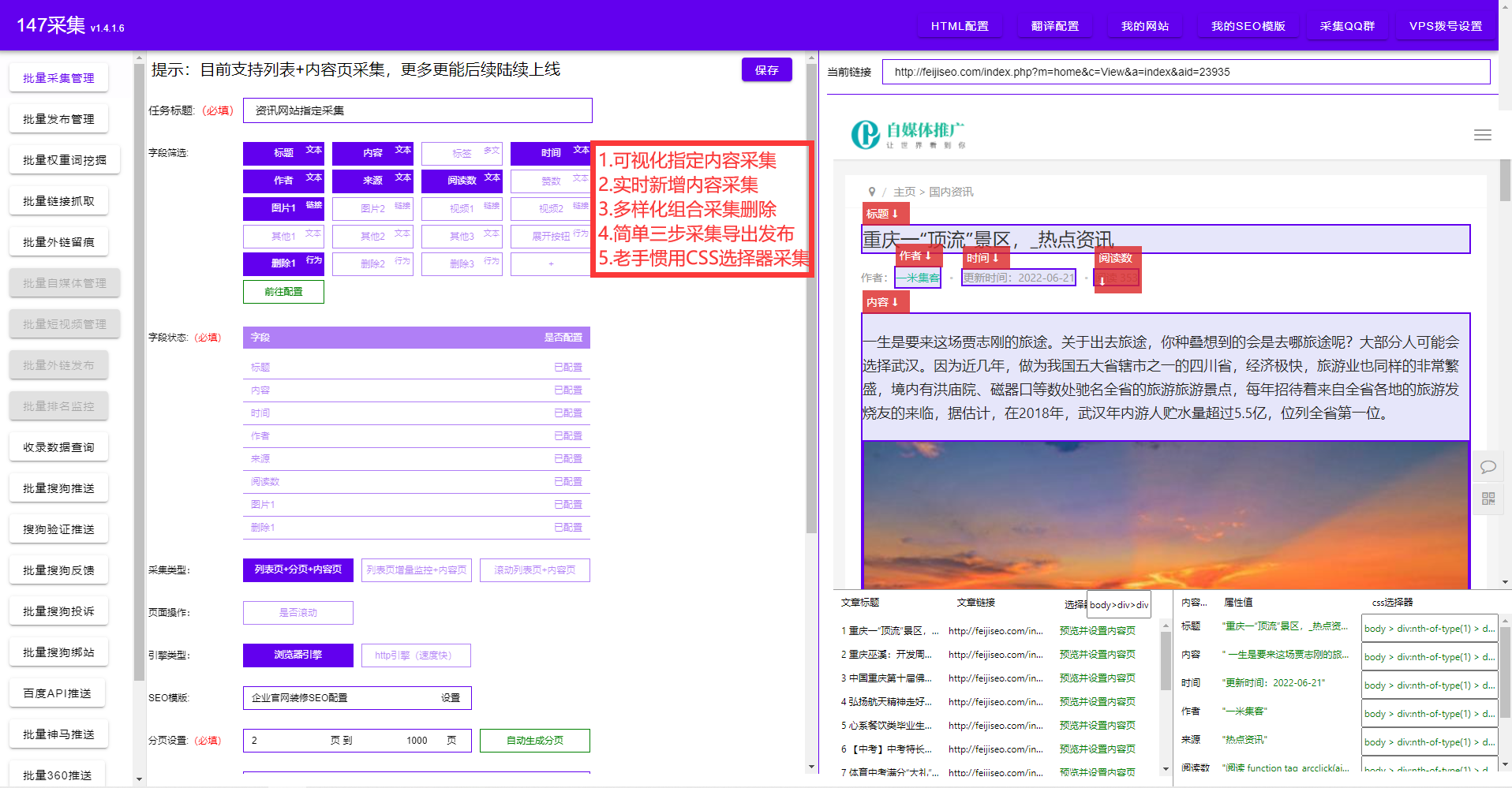

###数据爬虫的流程

数据爬虫的基本流程如下: 1.发起HTTP请求,获取网页内容。 2.解析网页内容,提取所需的数据。 3.保存数据。

##数据爬虫实战

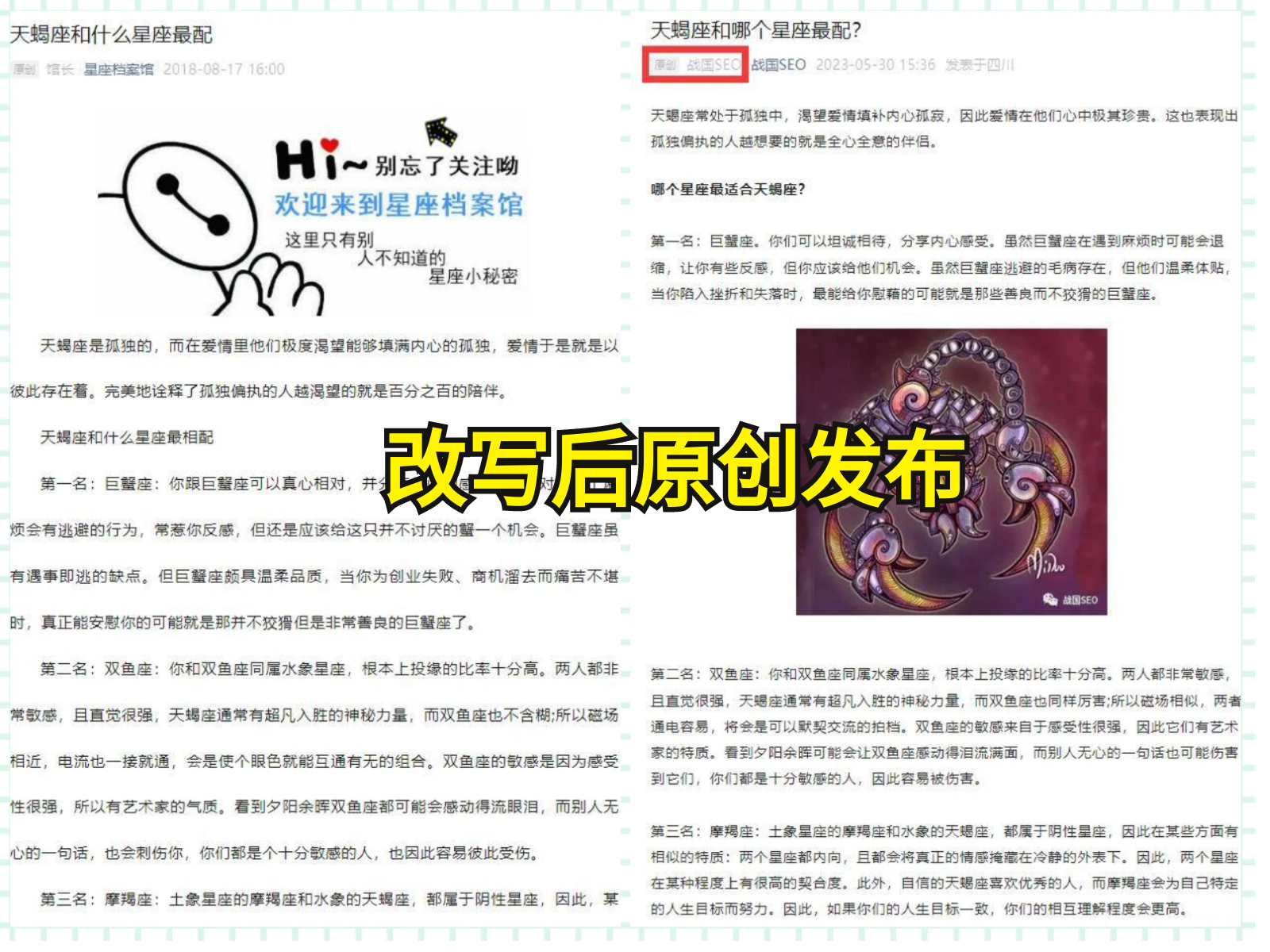

为了帮助读者更好地理解数据爬虫的实战应用,我们以一个简单的示例来演示整个过程。

首先,我们选择一个目标网站,比如电商网站上的商品信息。通过分析目标网站的网页结构,我们可以确定商品信息可能包含在哪些HTML元素中。

然后,我们使用编程语言编写爬虫代码。在Python中,使用Requests库可以方便地发起HTTP请求,使用BeautifulSoup库可以轻松提取网页内容。

最后,我们将提取到的商品信息保存至数据库或者文件中,方便后续使用。

##爬虫的注意事项

在进行数据爬虫时,需要注意以下事项: -尊重网站规则:遵守网站的Robots协议,不给网站带来过大的压力。 -频率限制:合理控制爬虫的访问频率,避免给网站带来过大的访问压力。 -数据使用合法性:获取的数据只用于合法目的,并且不侵犯他人权益。

##结语

本文只是给出了数据爬虫的一个简单示例,实际应用中还存在更多复杂的情况和技巧。希望通过该教程,读者可以掌握数据爬虫的基本原理和操作步骤,并能够在实际项目中灵活运用。数据爬虫有广泛的应用领域,掌握了这项技能,你将能够轻松获取所需的数据,为自己的工作带来更大的便利。让我们一起开始学习数据爬虫,开启数据世界的大门!