打造专业高效的通用爬虫抓取网页的流程

在当今的信息时代,数据成为了一个非常重要的ZY。而在获取各种信息数据的过程中,通用爬虫发挥了关键作用。通用爬虫是一种能够自动获取网页信息的工具,具有广泛的应用领域,包括数据分析、网页索引、价格监测等。

然而,要实现一个有效的通用爬虫并不简单,需要经过一系列的流程和技术处理。下面将介绍一套打造专业高效的通用爬虫抓取网页的流程。

1.确定需求和目标:在开始抓取网页之前,需要明确抓取的目标和需求。这包括确定所需的网站和页面,以及需要抓取的数据类型和规模。

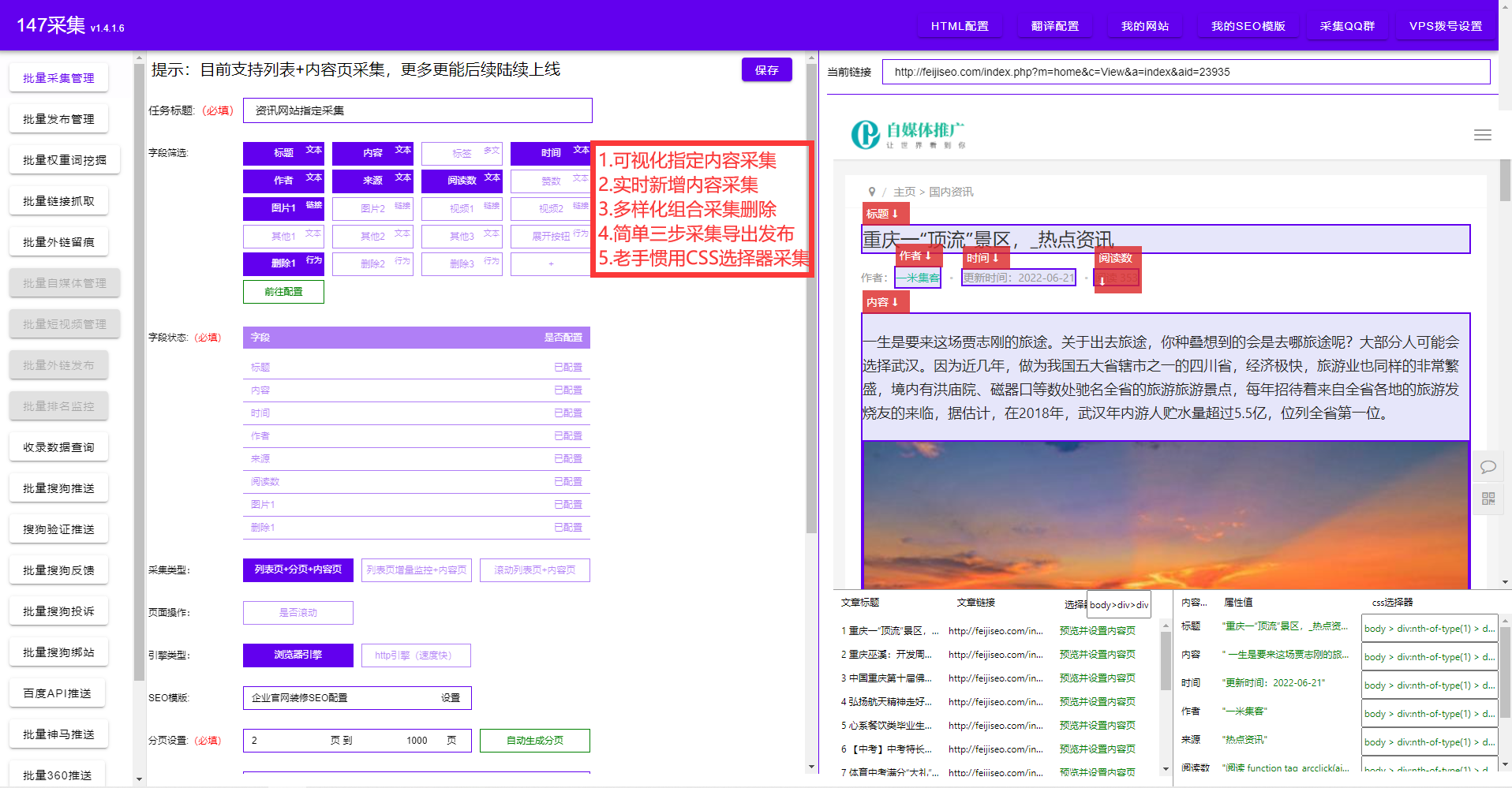

2.网页分析和规划:对目标网站进行分析,了解网页的结构和数据组织方式。同时,设计合适的抓取规则和策略,确保能够全面高效地抓取所需的数据。

3.编写爬虫程序:根据规划好的抓取策略,使用合适的编程语言和框架编写爬虫程序。爬虫程序应具备处理动态页面、反爬虫机制等问题的能力,并能够高效稳定地运行。

4.数据提取和清洗:在获取网页的源代码后,需要对其中的数据进行提取和清洗。通过使用正则表达式、XPath等技术,将所需的数据从网页中抽取出来,并进行清洗和整理。

5.存储和管理:抓取到的数据需要进行存储和管理。可以选择相应的数据库系统,例如MySQL、MongoDB等。对于大规模数据的存储和处理,可能需要使用分布式存储和计算框架,如Hadoop、Spark等。

6.数据分析和应用:抓取到的数据可以进行进一步的分析和应用。通过使用数据挖掘、机器学习等技术,对数据进行挖掘和发现隐藏的规律和价值,为后续的决策提供支持。

通过以上流程,可以帮助构建一个完善的通用爬虫系统,实现数据的快速采集和分析。然而,需要注意的是,在进行网页抓取过程中,要遵守法律法规和网站的规定,同时避免给目标网站带来不必要的负载和ganrao。

总结起来,通用爬虫抓取网页的流程主要包括需求确定、网页分析和规划、爬虫程序编写、数据提取和清洗、存储和管理、数据分析和应用等步骤。只有在每个环节都高效有效地进行处理,才能打造出专业高效的通用爬虫系统,并获得准确、丰富的数据ZY。